■Google Cloud Platform (GCP)

みなさん、Google Cloud Platform (GCP) は楽しんでいますか?AWS に多数インスタンスがある環境は相互運用って面倒だと勘違いしていませんか?個人的には AWS, Azure, Blumix, Cloudn, GCP はそれぞれ、使い分けや相互運用は可能であることを確認済みです。

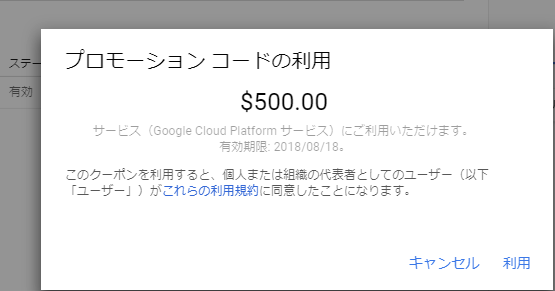

PaaS 各社はそれぞれ特徴があるので組み合わせて使いつつ、クラウド破産にならないように楽しみましょう。もしも、プロモーションコードをお持ちの方は1年間の無償または上限あり無償を使い切ってからプロモーションコードを適用しましょう(アカウント作成後にプロモーションコードを適用すると前述の1年間または上限あり無償の権利は無効となるよ~)。

※「閉域接続ではプロモーションコードは使えない」と GCNext’17 Tokyo 会場で展示員さんから聞いたので、仕事や学術研究でガッツリ GCP というか GCI を使う方は閉域接続を提供しているキャリアへご相談ください。いや、マジで俺も知りたい。

ーーー

■想定シナリオ

GCP へ何らかの入力を与え、学習パタンをもって出力生成したデータを普段使っている AWS S3 へ定期配信させたいが、

SDK を使うのが超メンドクサイ方。

具体的には、GCP VM 上に crontab から「1日1回 転送ジョブ」を書くのがメンドクサイ or シェルをろくに操作できない方向け。

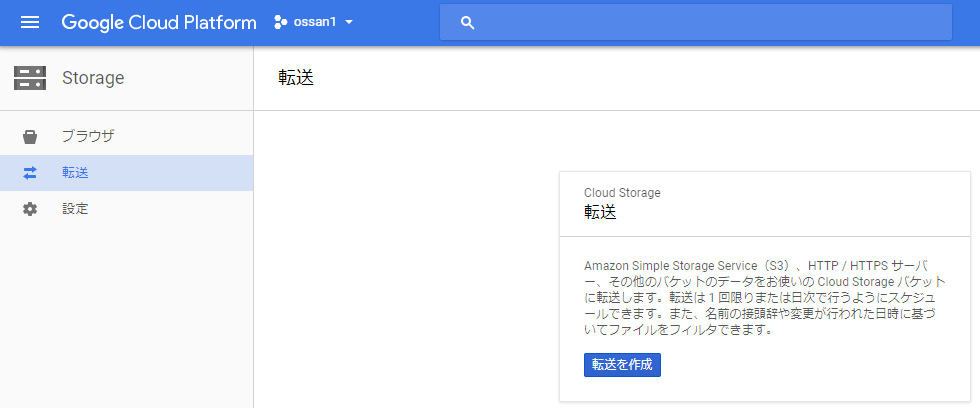

迷わず作成しましょう【GCPストレージ転送ジョブ】を。

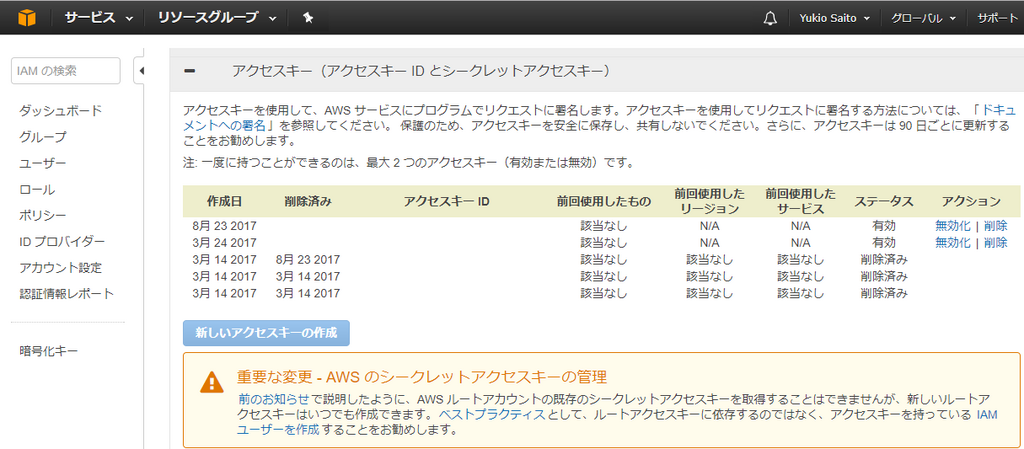

この時、必要となるのは AWS アクセスキーとシークレットアクセスキー(AWS ユーザにはお馴染み)。

↓

ここからは GCP 上での操作。

↓

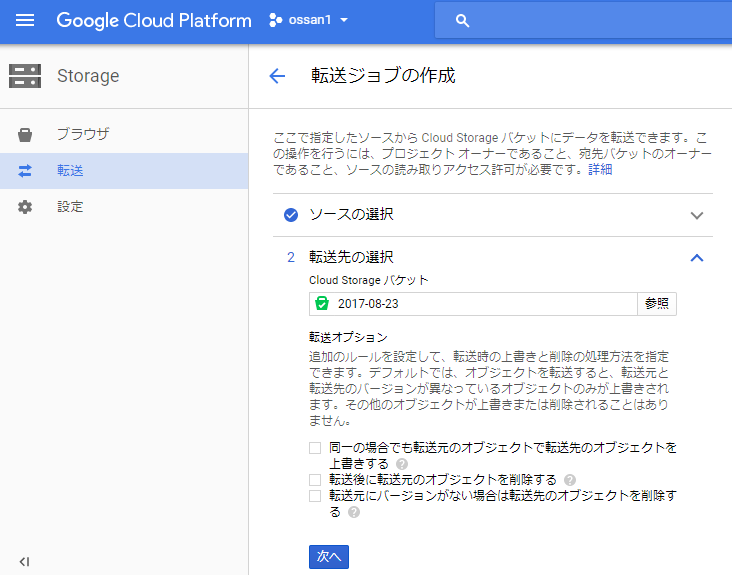

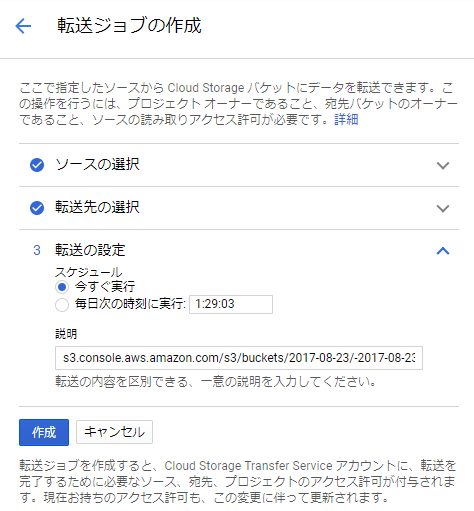

ソースの選択で AWS アクセスキー、シークレットアクセスキーが正しければ転送先に作成したバケットが表示されるよ。

↓

スケジュール指定はここで行います。今回は「今すぐ実行」を選択。

↓

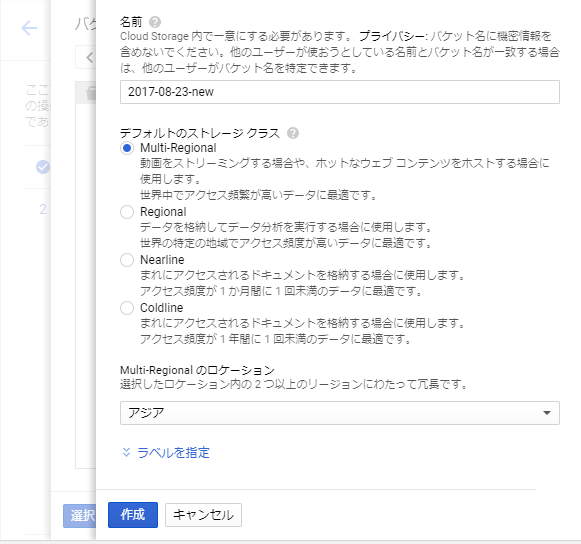

GCPストレージ側でバケット名の生成、デフォルトのストレージクラスの指定ができますが、クラウド破産しないように事前に何を指定(定義)するか考えてから望みましょう。クラウド破産までいかなくても、クラウド貧乏になる方は【要件定義、設計を完全無視】という方が少なくありません。クラウド利用は簡単とは言え、ほんとご留意くださいね。

ーーー

■動作確認のお時間です

↓

イケてない標準コンソール UI なので、自分のデータプロセス向けに SDK と緩やかなリミッタを使って「クラウド破産しない各種強制上限フラグを仕込む」などはいかがでしょうか。チュートリアルでもインスタンスはデプロイしてお終いではなく、インスタンス削除を実施するまでが一連の流れですよね。

ーーー

■緩いまとめ

AWS もいいけど、GCP もね!

以上